После прочтения “Грокаем машинное обучение” решил перейти к следующей книге по этой же теме и выбор пал на глубокое обучение, как крупную часть машинного обучения. И не прогадал, книга можно считать продолжением материала из предыдущей, или взглядом с другой стороны, так как подача сильно отличается.

В общем, выяснил я следующее: - все современные нейронные сети являются глубокими нелинейными сетями. Когда вы слышите о глубокой нейронной сети, с вероятностью более 90% в ее скрытых слоях используется ReLU или одна из ее улучшенных версий (как Leaky ReLU). И в этой книге как раз рассматриваются такие. Но, все начинается с одного нейрона и дальше уже развивается до глубоких сетей с краткосрочной памятью и федеративного обучения. Правда, о которых сказано очень мало, в сравнении с основным материалом, коим являются параметрические модели :) Наверное, на этом можно было бы и закончить, по тому что дальше остается только кратко её пересказать…

Как я уже говорил, материал в книге подается постепенно, от построения одного нейрона, дальше слоя из нескольких нейронов, после нескольких слоев и обратного обучения. Безусловно, кроме этих четырех пунктов в ней рассказывается и о функциях активации (все тот же ReLU), и о понятии архитектуры сети, о функциях потерь, о градиентном спуске, о проблемах переобучения и прочее, и прочее. В общем-то, книга дает крепкую базу. Все темы сопровождаются примерами кода, написанными на Python, причем какие-то примеры я запускал и не встретил никаких проблем.

Конечно, как уже говорил выше, книга не останавливается на одной архитектуре, она знакомит и со сверточными сетями, и с рекурриентными, например, но они рассматриваются уже на базе основного материала и без углубления. При этом всем в книге вообще нет формул, совершенно, что немного сбивает с толку, так как в той же “Грокаем машинное обучение” только формулы и используются.

Энивей, основного материала достаточно для того, что бы самостоятельно погрузиться в интересующую тему. В книге даже приводится пример написания собственного фреймворка, пусть и простого, но даже это дает представление о том, как работают всякие Keras и PyTorch под капотом. Есть ссылки для дальнейшего изучения, включая рекомендации литературы. В общем, мне книга зашла и даже очень! Но, я все совершенно не жалею, что прочитал обе, они дополняют друг друга.

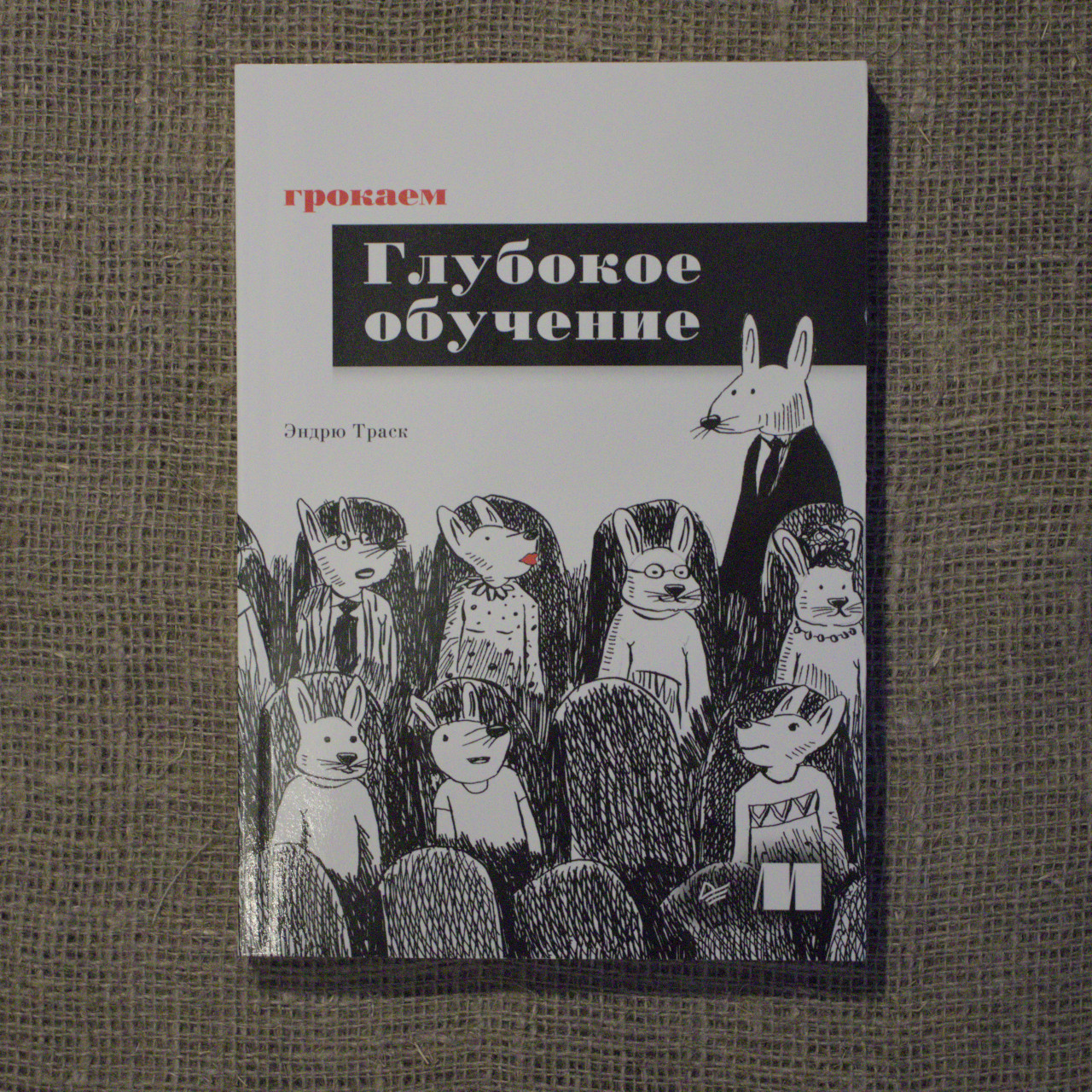

Что касается самого издания, то оно повторяет все остальные книги этой серии, разве что без дурацких иллюстраций и большого количества нелепых вставок, за что большое спасибо автору (или издателю, не знаю).

Автор(ы):

- Andrew W. Trask

Год издания: 2024

Количество страниц: 352

Оценка: 5/5

Издатель: Питер

Ссылка на страницу книги на сайте издательства: https://www.piter.com/collection/all/product/grokaem-glubokoe-obuchenie

Оригинальное название: Grokking Deep Learning

Год издания оригинала: 2019